حتى وقت قريب جدًّا كان من الممكن مواجهة الشائعات والأخبار الكاذبة عبر مبدأ بسيط جدًّا هو "صدّق فقط ما تراه عيناك". ولكن الآن وبسبب تطور تكنولوجيا Deepfake، أصبح ما تراه عيناك في بعض الأحيان أيضًا، من مواقف ومقابلات وفيديوهات وأصوات ومشاهد وأحداث، غير حقيقي، ولم يحدث بالمرة على الإطلاق، بل هو من وحي خيال الذكاء الاصطناعي فقط، بما يمثل تدشين مرحلة جديدة في حرب الشائعات ونشر الأخبار الكاذبة.

فهذه الفيديوهات المفبركة التي تراها عبر مواقع الإنترنت وشبكات التواصل الاجتماعي هي إما لأشخاص غير موجودين أساسًا، بل عبارة عن صور مُخلّقة عبر نظم ذكاء اصطناعي، أو لأشخاص حقيقيين لكن لم يتعرضوا لمثل هذه المواقف التي تراها من قبل، وقد لا يتعرضون لها في المستقبل أيضًا، ولم يُدلوا بالتصريحات التي سمعتها وشاهدتها على الإطلاق، ولكن استطاعت نظم الذكاء الاصطناعي أن تحاكي خصائص هؤلاء الأفراد والمشاهير بدقة كبيرة جدًّا إلى درجة يصعب اكتشافها، حتى استطاعت أن تخدعك وتجعلك تصدق ذلك الفيديو الذي يُدلي فيه "مارك زوكربرج" -على سبيل المثال- بتصريحات تسيء إلى فيسبوك، أو الفيديو الذي يظهر فيه الممثل الأمريكي الشهير "ويل سميث" على جسد مغنية الراب "كاردي بي"، أو غيره من آلاف الفيديوهات الموجودة عبر الإنترنت.

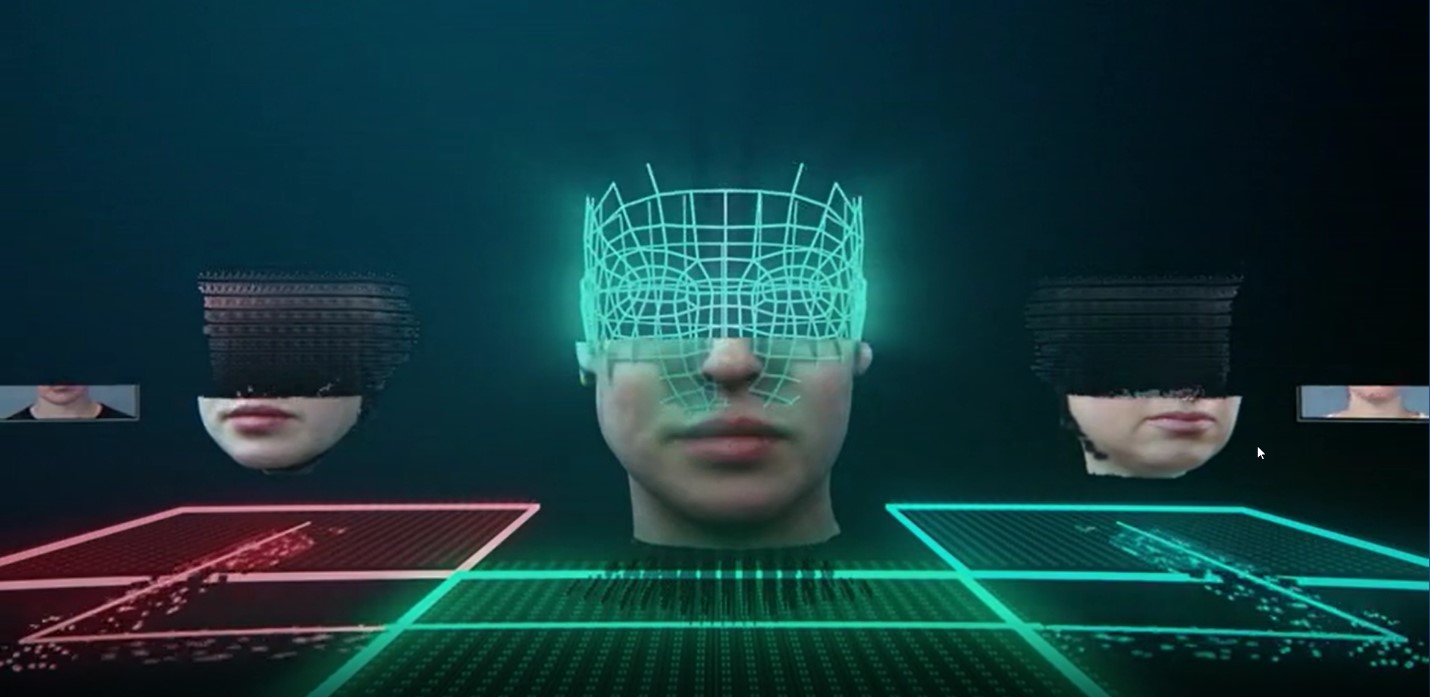

نموذج لـ Deepfakes

ما هو "الخداع العميق" أو deepfake؟

هي تلك التكنولوجيا التي تستخدم منهجية التعلم العميق Deep learning، التي تُعتبر أحد مكونات الذكاء الاصطناعي، بهدف عمل محاكاة غير حقيقية لموقف أو شخص تبدو وكأنها حقيقية ولكنها ليست كذلك على الإطلاق. ويأتي مصطلح deep من فكرة التعلم، وfake من فكرة الخداع والتزوير.

وللتوضيح أكثر، يمكن القول إنه إذا أراد أحد محترفي برنامج الفوتوشوب -على سبيل المثال- فبركة إحدى الصور عبر وضع وجه شخص مكان وجه آخر؛ فإنه يقوم بذلك عبر تغيير كل ملمح أو إطار Frame من هذه الصورة يدويًّا، حتى يصل إلى الشكل النهائي المطلوب، وهو ما يمكن للذكاء الاصطناعي أنه يقوم به بدقة أكثر وعلى نطاق أوسع.

ولا يقتصر الأمر فقط على الصور، بل يشمل أيضًا الفيديوهات والأصوات، وذلك من خلال قدرة نظم الذكاء الاصطناعي على التعلم عبر تغذيتها بعدد كبير جدًّا من الصور ومقاطع الفيديو والأصوات، ثم من خلال الخلايا العصبية الشبكية تقوم هذه النظم عبر خوارزميات ذكية، بفبركة وجوه وأشخاص وأصوات غير حقيقية، أو عمل محاكاة لهم تبدو وكأنها واقعية، لكنها غير حقيقية على الإطلاق.

ويحدث ذلك من خلال قيام نظام التعلم العميق deep learning بدراسة الشخصية المرجو محاكاتها أو تزويرها، وذلك عبر استخدام كميات كبيرة من الصور والفيديوهات التي تحاكي كافة زوايا الشخصية المطلوبة. فمثلًا يتم دراسة طريقة هذه الشخصية في الحديث من حركات الوجه والفم والعينين وحركات الأيدي والحركات اللا إرادية التي تقوم بها هذه الشخصية، ثم محاكاة نبرة الصوت الخاصة بها عبر استخدام كميات كبيرة من تسجيلاتها الصوتية، ومن ثم يقوم نظام الذكاء الاصطناعي بفبركة حديث كامل لهذه الشخصية لم تقم به من قبل على الإطلاق.

وقد شهد عام 2019 انتشارًا واسعًا لهذه النوعية من الفيديوهات المفبركة، وبصورة خاصة على مواقع التواصل الاجتماعي، سواء كان لقادة سياسيين أو فنانين وممثلين أو مديري شركات، يدلون بتصريحات غريبة أو يقومون بتصرفات غير منطقية، أو يتعرضون لمواقف غريبة، وقد يتسبب ذلك إما في إثارة الرأي العام وانتشار سريع لحالات الاعتداء، أو اهتزاز الثقة في أسهم إحدى الشركات في البورصة، أو غيرها من الأضرار المادية والمعنوية الناتجة عن عمليات الكذب والخداع والتزوير عبر تكنولوجيا "الديب فاك".

آلية عمل تكنولوجيا Deepfake:

يرجع الفضل في ابتكار هذه التكنولوجيا إلى Ian Goodfellow الذي أحدث ثورة جديدة في عالم الذكاء الاصطناعي وتعلم الآلات بفضل تطوير هذه التقنية، وقد حدث ذلك عام 2014 حينما كان فريق من الباحثين يعملون على برنامج لتعليم الكمبيوتر كيفية ابتكار الصور وتصميمها بنفسه، لكن واجهت هؤلاء الباحثين مشكلة رئيسية في أن الصور التي صممها الكمبيوتر كانت سيئة للغاية وبها أخطاء جسيمة، كأن يكون الوجهُ بدون أذنين مثلًا، فطلب هؤلاء الباحثون من "آيان جودفيلو" المساعدة.

وهنا قام "آيان" بإعادة توزيع الخلايا العصبية Neural Networks في برنامج الكمبيوتر الذي تم تصميمه، بحيث تكون في مواجهة بعضها بعضًا، وهو ما جعلها تتفاعل بصورة أكثر فاعلية من ذي قبل، وزاد من قدرتها على توليد البيانات.

وتُعتبر الخلايا العصبية بمثابة وحدات برمجية تقوم بوظيفة استقبال وإرسال البيانات التي يتم تغذية النظام بها. ومن خلال وضع هذه الخلايا في صورة متضادة مع بعضها ساعدها ذلك في توليد نماذج إحصائية ومعلوماتية أكثر مكّنت من رسم صور أكثر كفاءة ودقة.

ويحدث ذلك من خلال وضع خلية عصبية في مواجهة خلية عصبية أخرى، وكلا الخليتين مدربتان على نفس قواعد البيانات التي تم تغذية النظام بها. تقوم الأولى بمحاولة ابتكار وتصميم الصورة، وتقوم الثانية بدور المحقق أو المميز للاختلاف في الصورة، وذلك من خلال محاولة اكتشاف نقاط الخلل داخل هذه الصورة. ولذلك تسمى الخلية الأولى باسم المولد generator، والثانية باسم المميز discriminator. وعند قيام الخلية الثانية باكتشاف الخلل تحاول الخلية الأولى تصحيحه حتى تعجز الخلية الثانية عن اكتشافه، ومن ثم يخلق النظام الشكل النهائي للصورة التي يصعب اكتشاف تزويرها.

وقد سمى "آيان جودفيلو" هذا النموذج باسم Generative Adversarial Network أو "الشبكات التوليدية المتضادة" التي يُشار إليها اختصارًا باسم GAN، وقد اعتبرت بمثابة ثورة في نظم تعلم الآلات والذكاء الاصطناعي، حيث نقل الذكاء الاصطناعي من مرحلة التعرف على الأشياء إلى مرحلة خلق هذه الأشياء. ويعمل "آيان جودفيلو" حاليًّا في فريق "Google Brain" ذلك الفريق المسئول عن تطوير نظم الذكاء الاصطناعي في المقر الرئيسي بشركة جوجل في مونتين فيو في كاليفورنيا.

تهديدات أمنية متزايدة:

أحد أكثر التهديدات الحقيقية التي تسببها هذه التكنولوجيا هي فقدان الثقة في كل شيء، فلا يمكن تصديق ما تراه عيناك أو تسمعه أذناك بعد الآن، سواء كان ذلك حقيقيًّا أم لا، فأنت في حالة شك دائمة، وحالة عدم يقين مطلق. ففي تقرير صادر عن معهد ماساتشوستس للتكنولوجيا، اعتبر تكنولوجيا الخداع العميق بمثابة سلاح جديد قادر على التأثير على كافة الأشياء، من أسعار البورصة حتى الانتخابات، فقد أصبح الذكاء الاصطناعي قادرًا على وضع مشاهير في مشاهد إباحية، كما أصبح قادرًا أيضًا على استخراج الكلمات والتصريحات المستفزة والمثيرة من فم السياسيين ورجال الأعمال. ومن أشكال التهديدات الأمنية التي تطرحها تكنولوجيا الخداع العميق، هي:

1- فبركة تصريحات مسيئة لسياسيين، قد تؤدي إلى اندلاع أعمال عنف أو تظاهرات أو حتى توتر العلاقات مع دول أخرى.

2- خلق مشاهد كاذبة لأحداث عنف أو اعتداء، كمشاهد اعتداء الشرطة على المواطنين، وهو ما قد يستفز مشاعر الجماهير، ويجعلها تخرج في تظاهرات حقيقية ضد أجهزة الدولة.

3- التأثير على الانتخابات والعملية الديمقراطية من خلال فبركة تصريحات سياسية لمرشحي أحد الأحزاب أو قادة الحزب لا تتلاءم مع توجهات الناخبين، مما قد يدفعه لخسارة هذه الانتخابات.

4- فبركة مشاهد كاذبة بهدف الإساءة أو الابتزاز، كوضع صورة شخص في وضع مخل بالقواعد المتعارف عليها، أو وضعه في مكان لا يجب التواجد فيه بهدف الابتزاز أو الحصول على المال أو التشهير.

5- التأثير على أسهم الشركات والأعمال من خلال خلق صور وتصريحات مفبركة لمديري هذه الشركات تؤدي إلى الإضرار بأسهم الشركة وبموقفها المالي والاقتصادي.

ولما كان العام القادم 2020 هو عام الانتخابات الرئاسية الأمريكية، فإن البنتاغون يعمل من خلال وكالة مشاريع البحوث المتقدمة للدفاع (DARPA)، مع العديد من أكبر المؤسسات البحثية لمنع استخدام هذه التكنولوجيا في الانتخابات الأمريكية، واكتشاف الفيديوهات والصور ومقاطع الفيديو المزورة قبل انتشارها حتى لا تؤثر على توجهات الناخبين.

ولكن من أجل معرفة كيفية اكتشاف هذه الفيديوهات، تقوم DARPA أولًا بتطوير عمليات تصنيعها، وهو ما يحدث في جامعة كولورادو في دنفر، حيث يحاول الباحثون الذين يعملون في برنامج DARPA إنشاء مقاطع فيديو مقنعة وتبدو حقيقية، لكي يتم استخدامها لاحقًا بواسطة باحثين آخرين يقومون بتطوير التكنولوجيا لاكتشاف ما هو حقيقي وما هو مزيف.